随着元宵节的结束,我们挥别了过去一年,正式进入2021年的征程,春节期间的一切却仿佛还历历在目,回想起2021年春节联欢晚会频频霸占热搜,除却众星云集,还有一位“新朋友”登上舞台,带来令人印象深刻的春晚首秀,她就是中国第一位虚拟歌姬洛天依。

春晚舞台上,她与月亮姐姐、王源一起表演了少儿歌舞《听我说》,这不仅是虚拟偶像的一次大范围的“出圈”,也是春晚这一国家级平台对次元文化的尊重与认可,更是次元文化产品破壁生存与融合发展的一次有益尝试。

“虚拟偶像”一词,最初源于日本,是互联网思维下依托数字技术构建的虚拟形象。其中最具代表性的是日本虚拟歌姬初音未来。

如今的虚拟偶像主要分为以下几大种类:

01 虚拟歌姬&组合

传统的虚拟偶像,靠模型和音乐起家,有自己的人设和故事,会做音乐演绎和舞台表演,模型和设计也会不断调整,符合舞台表演类型,我们熟知的初音未来、洛天依就是此类虚拟偶像的代表。她们也是目前最为人熟知、最受人追捧的虚拟偶像。

2018年,基于“英雄联盟宇宙”IP的二次元虚拟偶像女团KDA横空出世,一出道即成为全球顶级流量,出道单曲登顶《公告牌》全球数字歌曲销量榜,出道MV播放量超4亿次。

2018年,基于“英雄联盟宇宙”IP的二次元虚拟偶像女团KDA横空出世,一出道即成为全球顶级流量,出道单曲登顶《公告牌》全球数字歌曲销量榜,出道MV播放量超4亿次。

02 时尚icon

她们的演绎方式与传统偶像不同,基本以图文为主,活跃于各大社交媒体,如火遍社交网络的美国虚拟偶像Lil Miquela,她是一位住在洛杉矶的20岁混血女孩,同时她还是模特和歌手,她有“自我意识”,支持黑人维权,穿着时尚。

Lil Miquela

在中国也有此类型的时尚icon,央视的选秀节目《上线吧!华彩少年》推出了虚拟女偶像“翎”,她是一个热爱国风文化的跨次元女孩,喜欢京剧,有着大家闺秀的气度,具有中国传统文化的气韵。她注重将国风和顶尖时尚潮流对接,直接打破了虚拟世界与现实世界的壁垒,将科技与中国文化深度结合。

翎Ling

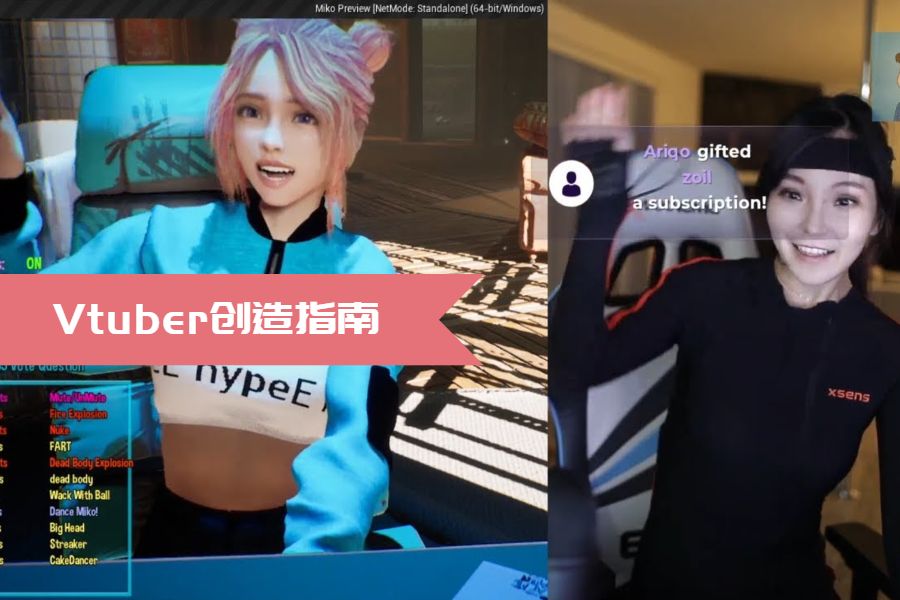

03 Vtuber

Vtuber是Virtual YouTuber的简称,最初指的是用虚拟形象活跃在YouTube上的视频主。其成本低互动简单,背后由真人演绎,扮演者则被称 为“中之人”。谈到Vtuber就必然避不开绊爱(Kizuna AI/キズナアイ)。自称是人工智能的绊爱从2016年末开始在YouTube活动,出道4个月订阅量便达到40万,2018年初订阅量变为上百万,成为迄今为止YouTube上订阅量最高的Vtuber。

虚拟YouTuber“绊爱”

Vtuber流传到国内后有着不同的名称:Vup、中V、虚拟主播、虚拟UP主。其中,中V对应日本Vtuber,指中国的Vtuber;虚拟UP主特指B站或A站(AcFun)上以虚拟形象方式来做视频的内容创作者;虚拟主播则可以囊括所有,甚至还包括B站以及A站以外平台上以虚拟形象做视频或直播的创作者。

“这几个称呼对虚拟IP的运营活动进行了更加细致的划分,但核心主体仍是一样的,就是一个虚拟的形象在做这些事。他们都是创作者,只是创作内容和平台不同,所以有了区分和不同的名称。“网易文创在接受采访时这样说道。

与传统的虚拟偶像相比,Vtuber不需要很强的技术支持,从制作技术上讲,以“爱酱”为代表的虚拟主播,强调与粉丝的互动,采用的主要是实时动捕、面捕技术;而以“初音未来”为代表的一代虚拟歌姬,主要在于“演唱”,采用vocaloid等软件发声。并且虚拟主播与虚拟歌姬最大的不同是其有自己独立的个性和思想。一千个人心中,可能有一千个初音,而虚拟主播在粉丝心中的形象则比较统一。

怎么样,看了上面的介绍,你是否也在为成为一名Vtuber而蠢蠢欲动呢,其实创建虚拟偶像并不难哦,尤其是在技术不断创新的今天。

那么,下面我们就来看看那些打造虚拟偶像需要用到的技术(这里侧重于针对使用 3D 形象进行直播的虚拟主播)。一般来说,创造虚拟偶像,主要包括这几个部分:动作捕捉、手势控制、表情控制、口型同步

动作捕捉

首先我们来看最重要的动作捕捉。根据实现的原理,动作捕捉方案可分为光学以及惯性两类。光学动捕需要在场地安置多台摄像机,这些摄像机同时对演员身上佩戴的光学标记进行识别,从而捕捉到演员的位置以及动作信息。惯性方案则是通过演员各关节佩戴的惯性传感器得到骨骼的旋转信息。

光学方案的优势在于精确度高,同时支持捕捉的人数多,并且可以取得绝对位置,便于演员之间、或者演员与物体之间的交互。而由于需要大量摄像机,因此初期成本、运营成本较高,对使用人员的技术要求也更专业。

这个银灰色短发的女孩儿名叫菲菲,是非凡传媒制作的第一位虚拟数字人类。菲菲的面部表情及肢体动作,则是通过拾取动捕和面捕设备数据同步到UE4中实时显示的。动作捕捉方面使用了Qualisys、MotionBulider,而面部捕捉则使用了iphone面捕技术。

这个银灰色短发的女孩儿名叫菲菲,是非凡传媒制作的第一位虚拟数字人类。菲菲的面部表情及肢体动作,则是通过拾取动捕和面捕设备数据同步到UE4中实时显示的。动作捕捉方面使用了Qualisys、MotionBulider,而面部捕捉则使用了iphone面捕技术。

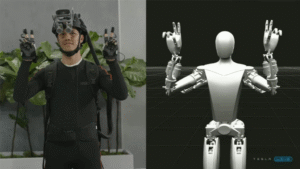

而惯性方案的优势在于设备成本低,使用方便,对场地要求较低,光学方案中可能出现的遮挡问题也能从原理上避免。虽然在精准度上不如光学动作捕捉设备,但是用于Vtuber直播是完全足够的。

Xsens 作为比较高端的惯性方案广泛应用于 VTuber 以及动画制作

以上是动捕系统的硬件层面。从软件层面来说,光学和惯性方案的方法差不多,要么提供可供 Unity 或者 Unreal Engine 使用的插件进行数据导入,要么可以将动作数据导入 Maya、MotionBuilder 之类的 3D 软件,再通过 MeshSync(Unity) 或者 LiveLink(Unreal Engine) 导入到引擎中。

手势控制

手势控制主要有三种方法:动捕方案自带的手势捕捉、独立的手势捕捉方案、在预设手势中选择。

动捕方案自带的手势捕捉

上文提到的 XSens MVN等惯性方案都可增配手势捕捉。如果动捕选择的是惯性方案,那么选择这些自带系统也是自然的延伸。

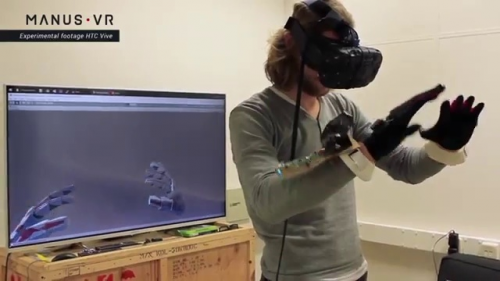

独立的手势捕捉方案

这个领域选择很多,比较常见的是跟随 VR 热潮起来的虚拟现实手套Manus VR。Manus手套的优点是即插即用,为手部数据的捕捉提供了专业、轻松的解决方案。

在预设手势中选择

除了上述两种依靠捕捉来控制手势的方法外,另一种常见的方法是通过控制器在预设的手势中选择。选用这种方案,面临的最主要考量是,控制器是由演员使用还是另外配备人员控制。如果是由演员实时控制,控制器就不能太复杂,相应的预设手势数量比较有限,如果专门配置人员使用,控制器的选择比较丰富,从键盘到游戏手柄到专门的外设都行,预设的手势数量也可以多些。

表情捕捉

表情捕捉算是虚拟偶像方案中除动作捕捉之外的另一个重要组成部分,主要有三种方案:图像识别、iPhoneX 深度摄像头识别、在预设表情中选择。

图像识别

这是传统的影视制作的表情解决方案。通过摄像头捕捉演员的面部表情,经由解析软件得到表情信息后,应用到虚拟形象上。这种方法的优点在于解析精度高,但费用较高。

iPhoneX 深度摄像头识别

这个方案发源于 2018 年,主要通过 iPhoneX 的深度摄像头识别人脸的表情信息,再转换为由苹果事先约定的 51 种微表情并进行组合,从而形成虚拟形象的表情。该方案的优势在于解析软件的门槛很低,Unreal Engine 和 Unity 都已经开源了实现方法,非常容易移植到自己的模型上。

在预设表情中选择

除了以上两种方法外,和手势一样,也可以通过控制器在预设的表情中选择。这种方法很适合表情不需要特别真实的二次元形象,而且还能用于星星眼之类无法通过人脸识别得到的夸张表情。

口型同步

最后是口型同步,主要方案有:图像识别、iPhoneX 深度摄像头识别、声量识别、音素识别。其中图像识别及iPhoneX 深度摄像头识别和表情捕捉大体一致,故不再赘述。

声量识别

即根据声量的大小来控制嘴巴张开的大小,一般分大中小三种,实现简单,但嘴型的变化十分小,较适用于二次元形象。

音素识别

这种方法通过语音识别,判断当前所发的是什么音,进而选取与该语音匹配的口型也是传统意义上的口型同步。目前比较常用的语音库是 OVRLipSync,或者 Unity 中的插件。

以上大致简略介绍了创建虚拟偶像所需的各个部分,用到的技术各有所长,适用于不同场合,需要根据实际直播或者动画制作的需求进行组合。当然具体实际的操作还需与相关技术人员进行沟通。我们也期待开发人员能在不久后的未来通过以上技术开发出更加简易便捷的操作系统,以创建出属于我们每个人自己的“虚拟偶像”。